新書推薦:

《

中国王朝内争实录(套装全4册):从未见过的王朝内争编著史

》

售價:NT$

1112.0

《

半导体纳米器件:物理、技术和应用

》

售價:NT$

806.0

《

创客精选项目设计与制作 第2版 刘笑笑 颜志勇 严国陶

》

售價:NT$

281.0

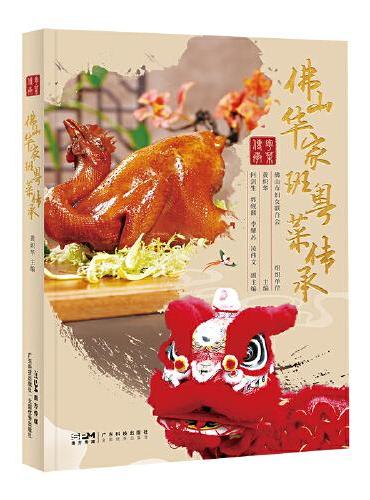

《

佛山华家班粤菜传承 华家班59位大厨 102道粤菜 图文并茂 菜式制作视频 粤菜故事技法 佛山传统文化 广东科技

》

售價:NT$

1010.0

《

武人琴音(十周年纪念版 逝去的武林系列收官之作 形意拳一门三代:尚云祥、韩伯言、韩瑜的人生故事 凸显百年武人命运)

》

售價:NT$

199.0

《

剑桥斯堪的纳维亚戏剧史(剑桥世界戏剧史译丛)

》

售價:NT$

704.0

《

禅心与箭术:过松弛而有力的生活(乔布斯精神导师、世界禅者——铃木大拙荐)

》

售價:NT$

301.0

《

先进电磁屏蔽材料——基础、性能与应用

》

售價:NT$

1010.0

|

| 編輯推薦: |

1.轻松学习掌握可快速分析大量数据的Apache Spark和云端的Databricks,低成本有效地获取数据中的高价值。

2.内容丰富详尽。不仅介绍了整合大量数据的方法,还讲解了云端分析、数据湖、数据摄取、体系结构和机器学习,以及Apache Spark、Apache Hadoop、Apache Hive、Python和SQL等相关工具。

3.讲解透彻易懂。理解底层技术,学会将云和Apache Spark融入数据分析,了解数据分析工具在现实世界中的具体用法。

|

| 內容簡介: |

Azure Databricks是一款基于云的大数据分析和机器学习平台,用于实现基于Apache Spark的数据处理,为快速增长的海量数据的处理和决策需求分析提供了良好的支撑。《Apache Spark大数据分析:基于Azure Databricks云平台》详细介绍基于Azure Databricks云平台来使用Apache Spark完成大规模数据处理和分析的方法。本书总计11章,首先介绍大规模数据分析相关的概念;然后介绍受管的Spark及其与Databricks的关系,以及Databricks的版本差异和使用方法(涵盖工作区、集群、笔记本、Databricks文件系统、数据导入/导出等内容);接着介绍使用SQL和Python分别实现数据分析的过程,数据提取、变换、加载、存储、优化技巧等高阶数据处理方法以及外部连接工具、生产环境集成等内容;后探讨了运行机器学习算法、合并数据更新以及通过API运行Databricks、Delta流处理等高阶主题。

作为数据分析领域的入门书,本书具有很强的实用性,可供数据工程师、数据分析师和决策分析人员等学习和参考。

|

| 關於作者: |

|

[瑞典]罗伯特·伊利杰森(Robert Ilijason),商务智能领域深耕20年的战场老兵,曾担任过欧洲一些大公司的外包人,并在零售、电信、银行、政府机构等领域做过大规模数据分析项目。多年来,数据分析领域的各种风尚潮起潮落,但他深信云端Apache Spark(尤其是与Databricks一起)与众不同,将是游戏规则的改变者。

|

| 目錄:

|

第 1章 大规模数据分析简介 1

1.1 宣传中的数据分析 1

1.2 现实中的数据分析 2

1.3 大规模数据分析 3

1.4 数据—分析中的燃料 5

1.5 免费的工具 6

1.6 进入云端 8

1.7 Databricks—懒人的分析工具 9

1.8 如何分析数据 9

1.9 真实世界的大规模数据分析示例 11

1.9.1 Volvo Trucks的远程信息处理 11

1.9.2 Visa的欺诈识别 11

1.9.3 Target的客户分析 12

1.9.4 Cambridge Analytica有针对性的广告投放 12

1.10 小结 12

第 2章 Spark和Databricks 14

2.1 Apache Spark简介 14

2.2 Databricks—受管的Apache Spark 16

2.3 Spark的架构 18

2.3.1 Apache Spark如何处理作业 19

2.3.2 数据 20

2.4 内核之上的出色组件 23

2.5 小结 23

第3章 Databricks初步 25

3.1 只能通过云来使用 25

3.2 免费的社区版 26

3.2.1 差不多够用了 26

3.2.2 使用社区版 26

3.3 梦寐以求的商业版 28

3.3.1 Amazon Web Services上的Databricks 29

3.3.2 Azure Databricks 32

3.4 小结 34

第4章 工作区、集群和笔记本 35

4.1 在UI中漫游 35

4.2 集群 38

4.3 数据 40

4.4 笔记本 42

4.5 小结 44

第5章 将数据载入Databricks 46

5.1 Databricks文件系统 46

5.1.1 文件系统导航 47

5.1.2 FileStore—通往自有数据的门户 49

5.2 模式、数据库和表 50

5.3 各种类型的数据源 文件 51

5.3.1 二进制格式 53

5.3.2 其他传输方式 54

5.4 从你的计算机中导入数据 54

5.5 从Web获取数据 56

5.5.1 使用shell 56

5.5.2 使用Python执行简单导入 58

5.5.3 使用SQL获取数据 60

5.6 挂载文件系统 60

5.6.1 Amazon S3挂载示例 61

5.6.2 Microsoft Blog Storage挂载示例 62

5.6.3 删除挂载 63

5.7 如何从Databricks中获取数据 64

5.8 小结 65

第6章 使用SQL查询数据 67

6.1 Databricks中的SQL 67

6.2 准备工作 68

6.3 选择数据 69

6.4 筛选数据 70

6.5 连接和合并 73

6.6 对数据进行排序 75

6.7 函数 76

6.8 窗口函数 77

6.9 视图 79

6.10 层次型数据 80

6.11 创建数据 82

6.12 操作数据 84

6.13 Delta Lake SQL 85

6.13.1 UPDATE、DELETE和MERGE 86

6.13.2 确保Delta Lake状况良好 88

6.13.3 事务日志 88

6.13.4 选择元数据 89

6.13.5 收集统计信息 90

6.14 小结 91

第7章 Python的威力 92

7.1 Python—不二的选择 92

7.2 加强版Python简介 93

7.3 查找数据 96

7.4 DataFrame—活动数据的居住之所 97

7.5 加载一些数据 98

7.6 从DataFrame中选择数据 101

7.7 串接命令 103

7.8 使用多个DataFrame 112

7.9 整理数据 118

7.10 小结 122

第8章 ETL和高级数据整理 123

8.1 再谈ETL 123

8.2 Spark UI简介 124

8.3 数据清理和变换 125

8.3.1 查找NULL 126

8.3.2 删除NULL 128

8.3.3 使用值来填充NULL列 129

8.3.4 去重 131

8.3.5 找出并清除值 132

8.3.6 处理列 135

8.3.7 转置 137

8.3.8 爆裂 138

8.3.9 什么情况下惰性求值有益 139

8.3.10 缓存数据 140

8.3.11 数据压缩 142

8.3.12 有关函数的简短说明 144

8.3.13 lambda函数 145

8.4 数据存储和混洗 146

8.4.1 保存模式 146

8.4.2 受管表和非受管表 148

8.4.3 处理分区 149

8.5 小结 154

第9章 在Databricks和外部工具之间建立连接 155

9.1 为何要在Databricks和外部工具之间建立连接 155

9.2 让ODBC和JDBC运转起来 156

9.2.1 创建令牌 157

9.2.2 准备集群 157

9.2.3 创建测试表 158

9.2.4 在Windows系统中安装ODBC 158

9.2.5 在macOS系统中安装ODBC 159

9.3 在外部工具中连接到Databricks 162

9.3.1 Microsoft Excel(Windows) 162

9.3.2 Microsoft Power BI桌面版(Windows) 163

9.3.3 Tableau(macOS) 164

9.3.4 PyCharm(通过Databricks Connect进行连接) 165

9.4 使用RStudio Server 168

9.5 访问外部系统 170

9.6 连接到外部系统 171

9.6.1 连接到Azure SQL 171

9.6.2 连接到Oracle 172

9.6.3 连接到MongoDB 174

9.7 小结 175

第 10章 在生产环境中运行解决方案 176

10.1 一般性建议 176

10.1.1 设想糟的情况 177

10.1.2 编写可反复运行的代码 177

10.1.3 对代码进行注释 177

10.1.4 编写简单易懂的代码 178

10.1.5 打印相关的信息 178

10.2 作业 179

10.2.1 调度 180

10.2.2 在笔记本中运行其他笔记本 181

10.2.3 小部件 183

10.2.4 运行接受参数的作业 185

10.3 命令行接口 186

10.3.1 安装CLI 186

10.3.2 运行CLI命令 187

10.4 再谈费用 193

10.5 用户、组和安全选项 194

10.5.1 用户和组 194

10.5.2 访问控制 195

10.5.3 其他特性 198

10.6 小结 199

第 11章 杂项 200

11.1 MLlib 201

11.2 频繁模式增长 201

11.2.1 创建一些数据 202

11.2.2 准备好数据 203

11.2.3 运行算法 204

11.2.4 分析结果 204

11.3 MLflow 205

11.3.1 运行代码 206

11.3.2 检查结果 208

11.4 更新表 208

11.4.1 创建源表 209

11.4.2 从Databricks连接到Oracle数据库 210

11.4.3 提取变更的数据 211

11.4.4 验证格式 212

11.4.5 更新表 212

11.5 Pandas简介 213

11.6 Koalas—Spark版Pandas 213

11.6.1 鼓捣Koalas 214

11.6.2 Koalas的未来 216

11.7 数据呈现艺术 217

11.7.1 准备数据 218

11.7.2 使用Matplotlib 219

11.7.3 创建并显示仪表板 220

11.7.4 添加小部件 220

11.7.5 添加图表 221

11.7.6 调度 221

11.8 REST API和Databricks 222

11.8.1 能够做什么 222

11.8.2 不能做什么 222

11.8.3 为使用API做好准备 223

11.8.4 示例:获取集群数据 223

11.8.5 示例:创建并执行作业 226

11.8.6 示例:获取笔记本 228

11.8.7 所有API及其用途 229

11.9 Delta流处理 230

11.9.1 运行流 231

11.9.2 检查和停止流 234

11.9.3 加快运行节奏 234

11.9.4 使用检查点 235

|

|