新書推薦: 《

三星堆对话古遗址(从三星堆出发,横跨黄河流域,长江流域,对话11处古遗址,探源多元一体的中华文明)

》 售價:NT$

398.0

《

迷人的化学(迷人的科学丛书)

》 售價:NT$

653.0

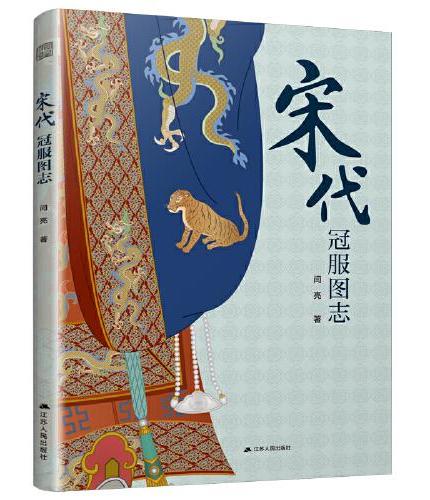

《

宋代冠服图志(详尽展示宋代各类冠服 精美插图 考据严谨 细节丰富)

》 售價:NT$

398.0

《

形似神异:什么是中日传统政治文化的结构性差异

》 售價:NT$

254.0

《

养育不好惹的小孩

》 售價:NT$

352.0

《

加加美高浩的手部绘画技法 II

》 售價:NT$

407.0

《

卡特里娜(“同一颗星球”丛书)

》 售價:NT$

398.0

《

伟大民族:从路易十五到拿破仑的法国史(方尖碑)

》 售價:NT$

857.0

內容簡介:

本书侧重于大数据的实践性技术,系统地介绍了主流大数据平台及工具的安装部署、管理维护和应用开发。平台和工具的选择均为当前业界主流的开源产品,因此,对于读者来说,有很强的可操作性。

關於作者:

祁伟:毕业于北京师范大学,目前担任《中国教育信息化》杂志社总编辑,具有超过20年的IT工作经验,在网络路由、服务器虚拟化、数据库等方面有深入研究和丰富的实践经验。

目錄

目 录

內容試閱

前 言